Google Bard est censé répondre à ChatGPT. Le géant de Mountain View a ouvert récemment l’expérimentation de Bard au public sur le continent américain. J’ai pu faire le test pour vous et je vous livre un petit comparatif entre les réponses de Google Bard et ChatGPT sur quelques points précis. Il y a de belles promesses de la part de Bard… Et du moins bien… Checkons ça !

Comment se présente Google Bard ?

Je vais le rappeler plusieurs fois dans cet article, Google Bard est encore en apprentissage. Pour l’instant, il est ouvert qu’au langage anglais. En conséquence, tous les exemples et impressions d’écran que vous verrez sont en langue de Shakespeare.

Google Bard est donc en train d’apprendre. Et on le repère très vite, car juste à côté du logo, on peut lire un petit encadré “Experiment”. Et si ça ne suffit pas, le robot nous en informe dans sa phrase d’accueil :

“I’m Bard, your creative and helpful collaborator. I have limitations and won’t always get it right, but your feedback will help me improve.”

bard.google.com

La première page est assez épurée et ne cherche pas à réinventer la roue. Sur le côté gauche, un menu avec quelques options :

- “Reset Chat” : pour effacer toutes les conversations sur l’écran.

- “Bard Activity” : pour consulter l’historique de toutes vos conversations.

- “FAQ” : pour accéder à une page de questions réponses

- “Updates” : pour consulter les mises à jour les plus importantes annoncées sur Google Bard.

- “Help & Support” : pour obtenir plus d’informations en cas de problèmes.

Petit aparté concernant l’historique. On peut consulter les anciennes requêtes faites à Bard, mais c’est très mal fait ! Ses réponses sont encastrées dans une petite fenêtre, sans saut de ligne et impossible de pouvoir réintégrer la discussion sans faire un copier-coller de la demande de nouveau sur la page principale.

Sur la partie centrale et sous la phrase d’accueil, Bard nous propose 3 exemples de questions ou d’idées pour commencer une conversation. Puis en regardant plus bas, on voit l’encart pour entrer nos fameux “prompts” (c’est-à-dire les indications qu’on souhaite soumettre au robot).

En petits caractères, sous cette barre de prompts, on voit que Google se protège avec la mention (ici traduite) : “Bard peut afficher des informations inexactes et offensantes qui ne représentent pas les idées de Google”.

Si on doit commencer à comparer avec ChatGPT, le robot OpenAI nous lâche aussi une petite phrase de la sorte, bien qu’un peu différente : “ChatGPT peut produire des informations inexactes sur des personnes, des lieux ou des faits”.

Pour résumer en image, voici à quoi ressemble la page de Google Bard lorsqu’on se connecte pour la première fois :

L’écriture d’un même article avec Bard et avec ChatGPT

Pourquoi on adore (ou déteste) tant ce type d’intelligence artificielle ? Parce que les robots peuvent faire des tâches en quelques secondes là où on prendrait plusieurs minutes, heures ou même jours. C’est évidemment le cas de la rédaction d’articles de blogs, de pages web, de notes, de livres, etc.

C’est donc le premier test que j’ai voulu réaliser. Voici le prompt, assez simple, proposé aux deux robots :

“Write a 300 words SEO page on the subject “how to write a good blog post” with strategic keywords for SEO. Make a H1 title, a little introduction then one H2 title, a paragraph, one H2 title an other paragraph and a conclusion”

En résumé, je lui demande un article bien optimisé sur le sujet “Comment écrire un bon post de blog”.

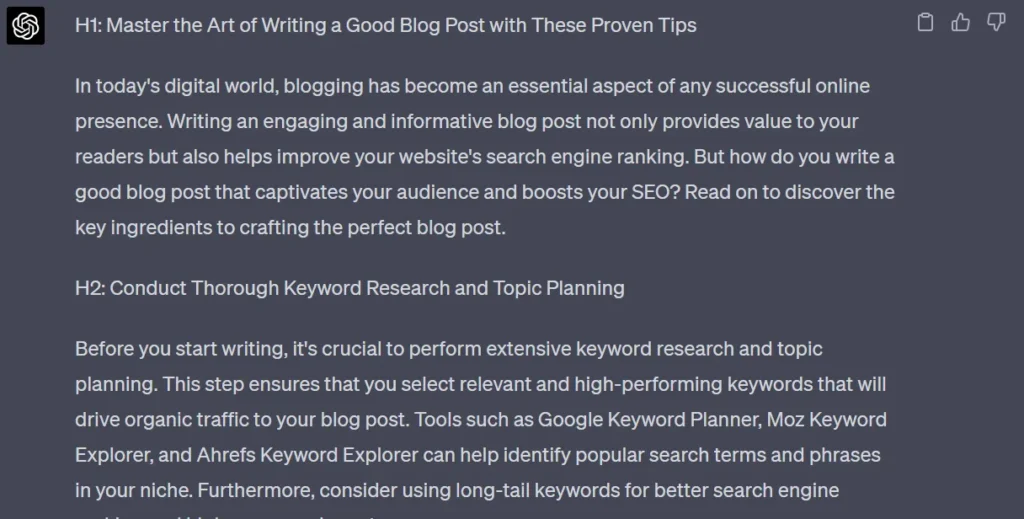

Voici un aperçu des premières lignes fournies par ChatGPT :

ChatGPT 4 respecte la consigne à la lettre au niveau du format. J’ai bien un titre H1, une introduction, un texte séparé par deux titres H1 puis une conclusion de quelques lignes.

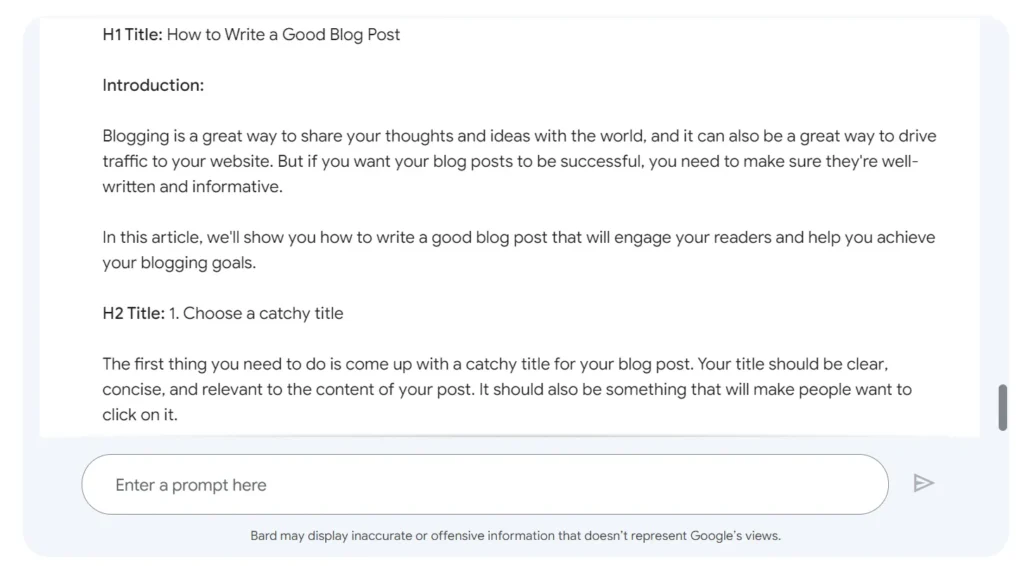

J’ai soumis exactement le même prompt à Google Bard. Première chose qui saute aux yeux : la proposition de plusieurs “Drafts”. En somme, Bard me propose non pas une mais 3 réponses différentes. C’est plutôt bien fait et ça nous permet de choisir les arguments qui nous conviennent parmi les différentes versions de réponses.

Les 3 vignettes sont bien visibles et si on ne veut pas les afficher, on peut simplement les réduire. Certes de nombreux arguments se retrouvent au sein de chaque vignette, mais c’est tout de même bien pensé et les textes sont cohérents.

Mais dans les 3 propositions, j’ai pu remarquer son manque de rigueur par rapport à ma demande. En effet, concernant le format, il me propose pas moins de 5 titres H2. Sur la Draft 2, le robot me fait même des titres H2 numérotés pour créer un article en format de liste. Même si c’est une proposition originale et qui peut s’avérer performante, ce n’est pas ce que je lui ai demandé.

Sur le fond des articles, les informations données par ChatGPT comme par Google Bard sont plutôt cohérentes, pas d’idées révolutionnaires, mais tout se tient.

Sur le style d’écriture, ChatGPT semble plus original. Il a d’ailleurs trouvé un titre H1 efficace et engageant. Google Bard n’a, quant à lui, pas changé le titre H1 dans ses versions, c’est simplement “How to write a good blog post”.

Tout au long de son article, Bard est plus formel dans son ton. Même si les paragraphes sont plus petits et donc plus lisibles, je suis davantage convaincu par la version de ChatGPT 4.

Sur la question du respect du nombre de mots, Google nous propose entre 350 et plus de 600 mots à travers ses 3 versions. ChatGPT lui nous génère un texte d’environ 400 mots.

Qui résume le mieux un texte ? Google Bard ou ChatGPT ?

L’une des autres utilisations les plus simples et efficaces de ce type d’intelligence artificielle consiste à nous résumer un texte pour en tirer les idées les plus importantes. Pour faire le test, j’ai été tout simplement sur le blog The Keyword de Google et copié le texte de cet article : https://blog.google/technology/ai/bard-google-ai-search-updates/. Et j’ai pu constater quelques différences entre les réponses de ChatGPT et Bard.

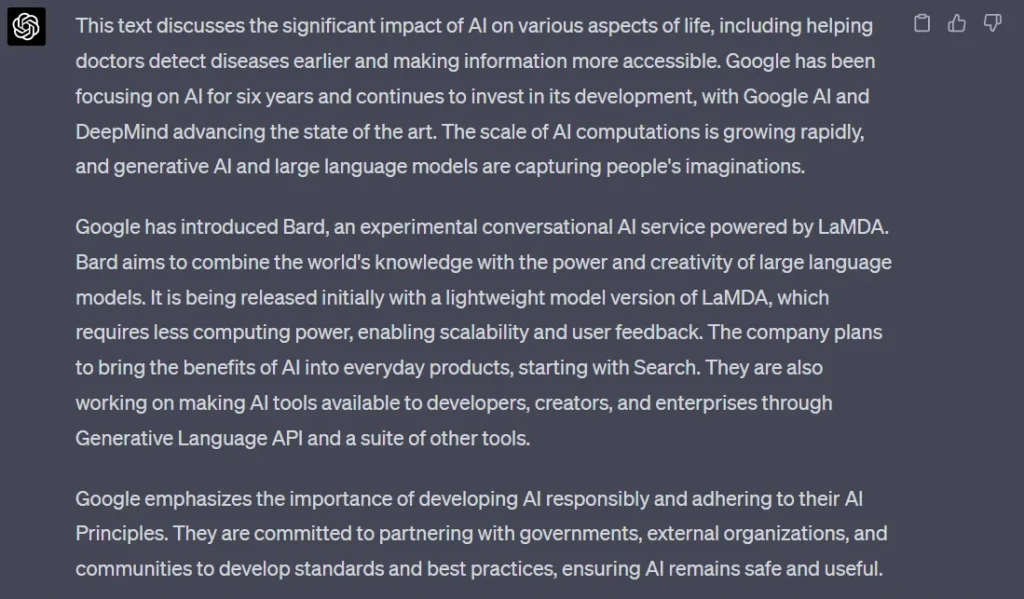

Tout d’abord ChatGPT nous balance 3 bons paragraphes plutôt complets. Les informations principales sont bien présentes selon moi :

Pour la version de Google Bard. On voit tout de suite une différence. Le robot nous propose une liste point par point, c’est plutôt astucieux pour faciliter la lecture. Et on retrouve toujours 3 types de propositions avec chaque Draft :

En revanche, si l’idée de la liste est assez bonne, dans cet exemple, je trouve qu’il y a un peu trop de points listés, ça hache la lecture.

Aussi, il est drôle de voir quelques différences au niveau du contenu entre Bard et ChatGPT. ChatGPT cite notamment des notions importantes comme le modèle de langage LaMDA, là où le robot Google ne parle que de LLM.

Celui d’OpenAI évoque aussi le laboratoire de recherches sur l’intelligence artificielle DeepMind, contrairement à son concurrent.

ChatGPT ferait-il un meilleur résumé sur l’activité de Google que Google Bard lui-même ? Surprenant ! Ou pas…

Car si on cherche bien, ces notions sont retrouvées dans les 2 autres Drafts. Avec cette solution, Google a été intelligent, il est sûr d’être le plus exhaustif possible…

En revanche, notre flemme ne le remercie pas parce que c’est à nous de compiler les informations qui nous intéressent.

Trouver des mots-clés avec Bard et ChatGPT 4

L’intelligence artificielle peut aussi nous donner des idées SEO de mots-clés pertinents sur une thématique. À ce propos, “l’article Google Bard aura-t-il un impact sur le SEO” évoque notamment les changements probables en matière de référencement avec l’arrivée de l’IA sur nos moteurs de recherche.

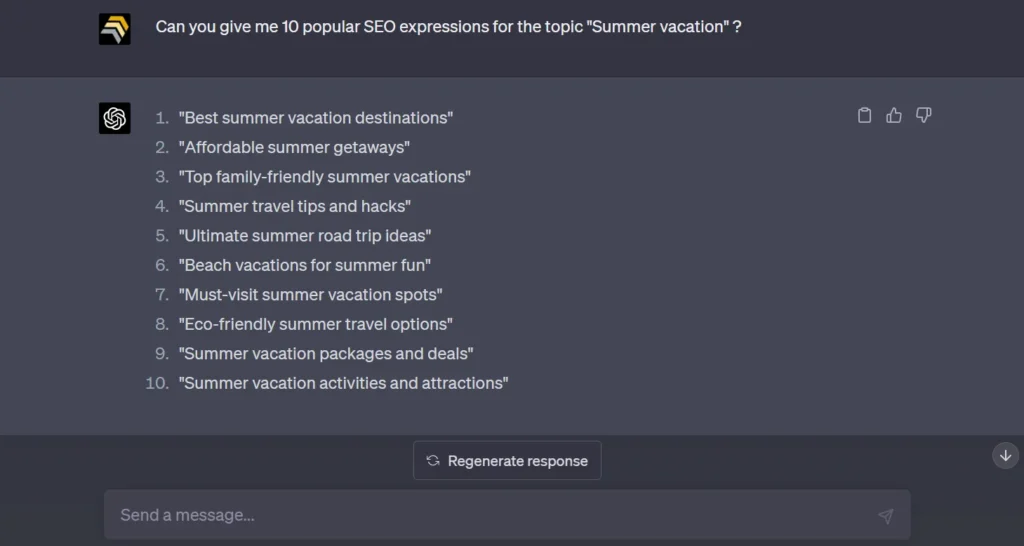

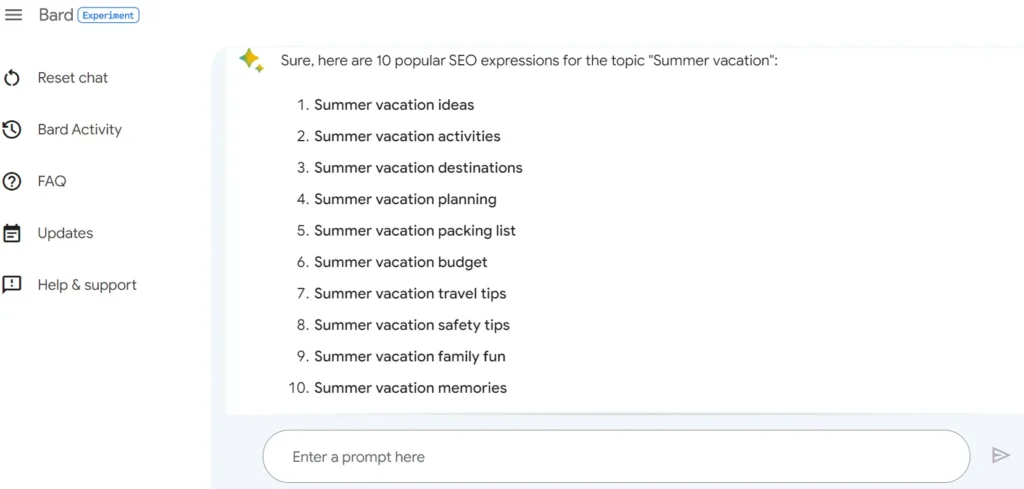

J’ai donc simplement demandé 10 expressions populaires sur le thème “vacances d’été” à ChatGPT d’abord :

Puis à Google Bard ensuite :

Les résultats sont vraiment différents selon moi. ChatGPT a compris ma demande et a affiné sa réponse en proposant des expressions précises et originales.

Google Bard a compris aussi le prompt, mais il n’a pas été cherché très loin pour répondre. Les mots-clés sont des occurrences assez simplistes commençant toutes par “Summer vacation”. On se croirait presque dans la barre Google Suggestion !

Encore une fois, les idées de ChatGPT 4 sont plus engageantes, alors que Bard a proposé des expressions très génériques.

Qui de Google Bard ou ChatGPT écrit les meilleurs tweets ?

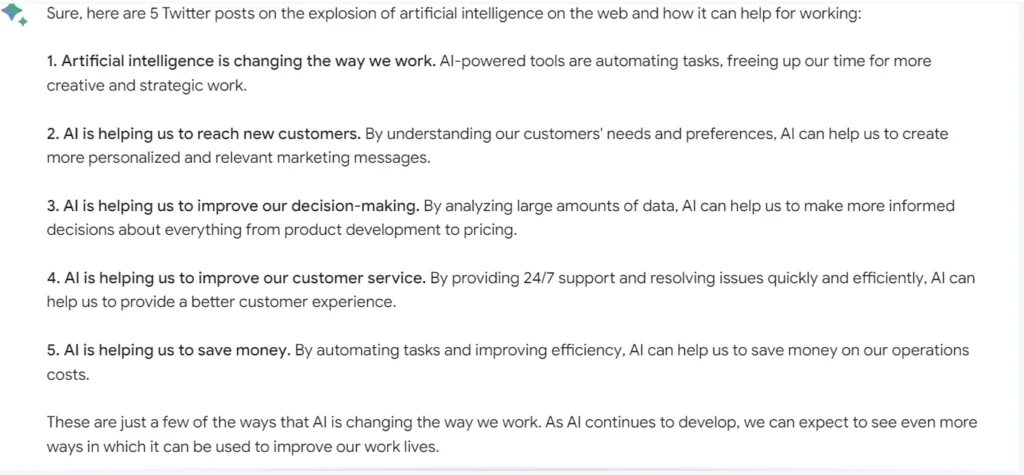

L’IA peut aussi nous aider à écrire des posts sur les réseaux sociaux. J’ai donc voulu faire l’essai de demander à nos 2 robots de rédiger des posts Twitter sur le thème de l’intelligence artificielle.

Pour info, voici le prompt exact en anglais :

“Imagine you are a digital marketer influencer, write 5 Twitter posts on the explosion of artificial intelligence on the web and how it can help for working. Make the post engaging to get retweets, follows and favorites“.

Découvrons tout de suite la réponse version ChatGPT 4 :

En comparaison, voici la proposition de tweets faite par Google Bard :

La différence est assez flagrante dès le premier coup d’œil. Encore une fois, ChatGPT s’est bien mis dans la peau de notre influenceur en marketing digital. Tout y est, les posts n’ont plus qu’à être programmés sur Twitter.

Google Bard lui, nous a livré des posts très froids, sans aucun relief. Ici pas d’émojis, pas de hashtags. La plupart des tweets commencent par les mêmes mots. Le résultat est vraiment décevant.

Et pour le développement, Google Bard vs ChatGPT 4, ça donne quoi ?

L’intelligence artificielle est un formidable outil pour aider le développement, que ce soit pour la création d’un code complet ou pour le debug. J’ai donc voulu tenter l’expérience en demandant aux 2 robots de créer un code simple pour jouer au jeu du pendu.

J’ai choisi le langage de programmation Python, car les deux IA savent l’écrire. Pour le moment, Google Bard peut coder une vingtaine de langages comme C++, Go, Java, JavaScript ou encore TypeScript.

En moins d’une minute, ChatGPT 4 m’a créé un script Python qui tourne sur le terminal de commande. Habituellement, il faut plusieurs essais pour que le code fonctionne, tout a été parfait du premier coup ! C’est sommaire, mais ça marche !

En revanche, sur Google Bard, l’expérience n’a vraiment pas été concluante, même pas du tout. Lors de ses premiers essais, il a envisagé de réaliser une sorte de tableau pour représenter le dessin du pendu, mais rien n’a fonctionné. J’ai passé plus de 30 min à tenter de lui faire “débugger” son propre code, mais il n’y est pas arrivé.

Volontairement, je n’ai pas souhaité lui refaire de prompt trop détaillé, car ce serait injuste pour la comparaison avec ChatGPT. Pour chaque erreur, je lui communiquais l’erreur en question, soit il reproduisait l’erreur, soit il en fournissait un autre code avec d’autres erreurs ou des dysfonctionnements.

En plus, généralement, suite aux prompts sur ChatGPT concernant la programmation, le robot nous transmet le code et nous explique quelques détails de celui-ci ou des corrections apportées.

Google Bard lui nous transmet le code tel quel et nous dit juste que cela devrait fonctionner. Si on ne lui demande pas d’explications, il n’en fournit pas ou très peu.

En revanche, pour trouver un point positif à Google Bard, l’interface nous propose un accès direct à Google Colab, qui nous permet de tester directement notre code, ce que ChatGPT ne propose pas.

Bonus : ChatGPT ou Bard, qui fait les meilleures blagues ?

Pour finir, je me suis amusé à comparer l’humour de ChatGPT à celui de Google Bard. Malheureusement mon premier prompt n’a pas fonctionné sur Google Bard. Pour le coup, c’est un peu ma faute… L’outil est encore en développement et seulement accessible aux USA. Et j’ai demandé des blagues concernant les Français ou la France. Il n’a pas bien compris ma requête et s’est excusé de ne pouvoir répondre.

En revanche, pas de problème pour ChatGPT. Voici 2 exemples plutôt drôles :

Why was the French football team always so calm on the field? They knew they had nothing Toulouse!

ChatGPT

What do you call a Frenchman wearing sandals? Phillipe Phillope!

ChatGPT

Du coup, j’ai changé mon fusil d’épaule avec un nouveau prompt donné aux deux robots : “Make 5 hilarious jokes about moms“.

Les réponses de ChatGPT :

Et les réponses de Google Bard :

Bon, après, c’est de l’humour classique de robots, et évidemment, c’est subjectif !

Conclusion sur les performances de Google Bard vs ChatGPT 4

Dernier rappel, Google Bard n’est qu’en version test. Et on voit bien que l’outil n’est pas encore au point. Il a encore pas mal de choses à apprendre, notamment sur ces manières de comprendre les prompts avec subtilité.

Sa rapidité d’exécution est néanmoins acceptable et similaire à ChatGPT. On préfèrera toutefois l’écriture en direct (comme à la machine à écrire) du robot d’OpenAI, qui nous tient en haleine.

Il y a toutes fois des choses intéressantes comme la proposition des Drafts supplémentaires sans qu’on ait à retaper un prompt. Mais aussi le lien direct vers Google Colab pour tester un morceau de code.

En tout cas pour l’instant ChatGPT n’a pas de souci à se faire… Affaire à suivre !